阅读笔记作者:李婧

备注:

1、论文阅读笔记将同步更新到四川大学网络空间安全协会学术园地版块(https://www.scucyber.cn/explainable-fake-news-detection-with-large-language-model-via-defense-among-competing-wisdom-论文阅读笔记/);

2、论文阅读笔记需要同时通过Synology Drive上传到资源共享平台和协会学术园地版块收稿邮箱1092477425@qq.com并抄送到whzh.nc@scu.edu.cn,邮件中注明该文档在网站发布时的作者为本人真实姓名还是昵称(昵称命名不得违规)。

1 原文作者

Bo Wang(School of Artificial Intelligence, Jilin University Changchun, China Hong Kong Baptist University Hong Kong SAR, China), Jing MA(Hongzhan Lin Hong Kong Baptist University Hong Kong SAR, China), Zhiwei Yang(Guangdong Institute of Smart Education, Jinan University Guangzhou, China), Ruichao Yang(Hong Kong Baptist University Hong Kong SAR, China), Yuan Tian(School of Artificial Intelligence, Jilin University Changchun, China), Yi Chang(School of Artificial Intelligence, Jilin University Changchun, China).

2 论文来源

WWW ’24: Proceedings of the ACM on Web Conference 2024

3 论文地址

https://dl.acm.org/doi/pdf/10.1145/3589334.3645471

4 论文简介

大多数假新闻检测方法基于神经网络学习潜在特征表示,是黑盒模型,在对新闻进行分类时无法给出任何理由。现有的可解释系统通过调查性新闻可以生成真实性证明,但这些系统存在辟谣延迟和效率低下的问题。最近的研究简单地假设,证明辟谣等同于群众智慧中表达的大多数意见。然而,由于群众智慧未经过审查,这些意见通常包含一些不准确或有偏见的信息。为了从多样化、拥挤甚至竞争的叙述中检测假新闻,本文提出了一种新的基于防御的可解释假新闻检测框架。具体来说,我们首先提出了一个证据提取模块,将群众智慧分为两个对立的阵营,并分别检测显著的证据。为了从证据中获得简明的见解,我们设计了一个基于提示的模块,利用大型语言模型通过推理两个可能的真实性生成证明。最后,我们提出了一个基于防御的推理模块,通过对这些证明之间的辩护建模来确定真实性。在两个真实世界基准上进行的大量实验表明,我们提出的方法在假新闻检测方面优于最先进的基线,并提供高质量的证明。

5 解决问题

这篇论文旨在通过开发一种方法来改进假新闻的自动检测,不仅能识别错误信息,还能以透明和可信的方式解释其结论,从而应对假新闻带来的社会挑战。

假新闻的危害:社交媒体上假新闻的普遍问题及其对个人和社会造成的不利影响,特别是在COVID-19大流行期间,关于疫苗的误导性信息影响深远。

解决当前方法的局限性:现有的假新闻检测方法通常依赖于深度学习技术,其作为黑盒的特性使其无法提供明确的分类理由。这种局限性阻碍了公众的信任和理解。

设计具有解释性的模型:论文强调了可解释的假新闻检测(EFND)的重要性,不仅能预测新闻的真实性,还能提供易于理解的解释。受到众包事实检查有效性的启发,论文建议利用原始报告中包含的智慧,将这种智慧分为两种对立的观点(支持和反驳),引入了一种基于防御的框架,整合了大型语言模型(LLMs)的先进推理能力,旨在生成与人类专家推理相媲美的解释,而无需监督辟谣报告。

6 本文贡献

(1)提出了一种基于防御的框架,利用原始报告(report)中天然包含的丰富竞争性智慧,从而减轻现有工作中存在的大多数偏见问题。

(2) 整合了大型语言模型(LLMs)强大的推理能力,使得我们的模型能够生成与人类专家相媲美的解释,而无需依赖已被辟谣的报告进行监督。

(3) 在两个可解释假新闻检测数据集上取得了新的最先进结果,并通过广泛的分析展示了解释的质量。

7 论文方法

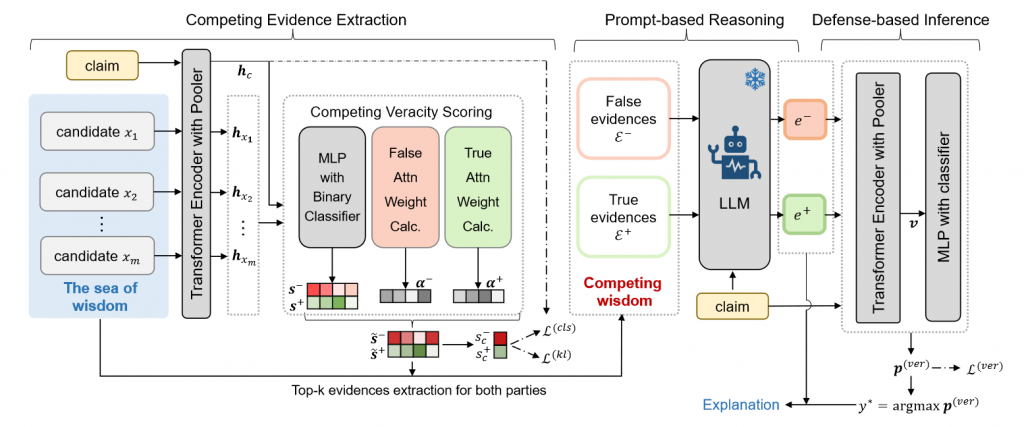

如图7-1是论文的模型架构图。

7.1 任务定义

给定一个与真实性标签y相关联的新闻主张c及其相关原始报道,其中每个di表示由一系列句子组成的相关报道,EFND的目标是预测主张c的真实性标签y∗并提供有关预测的解释e,对于不同的数据集,y∗可以是集合{false, half, true}中的一个,也可以是集合{pants-fire, false, barely-true, half, mostly-true, true}中的一个。

7.2 竞争性证据提取

目标:将大量的信息分成两个竞争方,并提取各自的证据以便后续比较。

7.2.1 声明和证据表示

(1)报告可能包含指示不同真实性的证据,因此将报告分解为单个句子,形成候选证据句子的语料库。

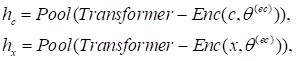

(2)使用预训练的Transformer编码器生成声明和候选证据的表示:

其中Pool(·)收集了[CLS]的结果,表示序列的上下文表示。

7.2.2 竞争性真实性评分

每个候选句子被赋予两个真实性分数 “false score”和“true score”,分别表示支持声明为假的或真的程度。

(1)使用自然语言推理(NLI)领域的交互级联方法计算每个候选句子的真和假得分:

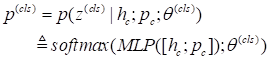

(2)使用两分类器对𝑢进行分类,生成真假两个维度的概率分布:

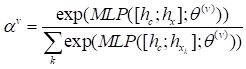

(3) 通过注意力权重计算模块来提升证据排序的准确性,计算假(真)的注意力权重:

因此,用于排序的候选证据的最终假(真)分数为:

(4)通过候选证据的竞争性真实性分数,可以得到声明的竞争性真实性分数:

这可以用来判断声明的真实性。

7.2.3 训练和推理

(1)训练

使用两个损失目标进行临时真实性预测,并考虑提取竞争性证据。主要目标是使用竞争性真实性分数来排名和提取两组竞争性证据。使用KL散度:

这种软KL损失不适合推理目的,它与声明的连接不够强。因此,我们进一步定义了一个用于临时三分类真实性预测的神经分类器:

训练该模块的分类目标是:

在我们提出的提取模块中,我们对可学习参数进行了训练,以获得两种损失的线性组合,即:

(2)推理

在优化提取模块关于L(ext)的情况下,推断中产生的s~-和s~+可用作排名依据。对于所有的候选证据,它们将分别基于s~-和s~+进行两次排名。选取k个假证据和真证据的集合ε–和ε+,准备用于后续章节描述的基于提示的推理模块。

7.3 基于提示的大语言模型推理

为了有效利用大量竞争性证据中包含的信息和合理性,我们开发了一个基于提示的模块,进一步筛选和总结这些证据。我们使用LLM进行溯因推理(abductive reasoning),以解释为什么声明为真或假的原因.

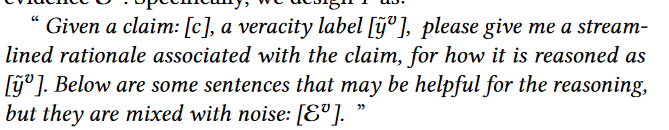

(1)输入模板设计

给定一个声明c,一个先验标签和一个证据集Ev:

模版设计如下:

7.4基于防御的推理

首先,我们连接输入的三个文本并将它们输入到预先训练的 Transformer 编码器中以进行上下文表示。

这种表示可以有效地捕获这三个文本之间的语义差异和联系。然后,我们在其丰富的表示之上定义一个分类器以进行准确性预测:

检测任务的训练目标为:

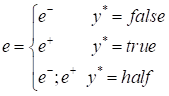

推理过程可以简单地写为:

根据模型的预测,我们选择相应的解释作为最终的解释e,可以写为:

在“一半”预测的情况下,为了帮助用户理解声明的错误方面和真实方面,我们利用模板将两个解释连接起来并同时呈现两种解释。这种方法确保最终的解释与预测的准确性标签保持一致。

8 实验结果

8.1数据集的选择

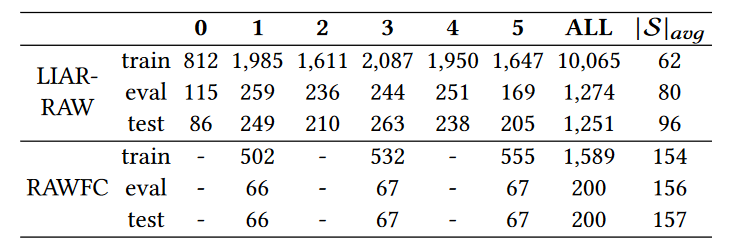

本文在两个可解释的数据集RAWFC和IAR-RAW上进行实验,这两个数据集分别基于两个英文事实核查网站(Snopes和PolitFact)进行构建。数据集情况如表8-1所示:

8.2基线模型的选择

(1)传统非LLM方法

dEFEND、SBERT-FC、GenFE、GenFE-MT、CofCED

(2)基于LLM的方法

LLaMA2claim,直接通过提示新闻声明来生成真实性预测和相应的解释

ChatGPTclaim,直接通过提示新闻声明来生成真实性预测和相应的解释

ChatGPTfull,除了新闻声明,还提示所有相关报道内容

FactLLaMA ,利用LORA调优对一个LLaMA进行有监督的微调

FactLLaMAknow,与FactLLaMA相比,从搜索引擎检索的外部相关证据。

8.3 实验结果和分析

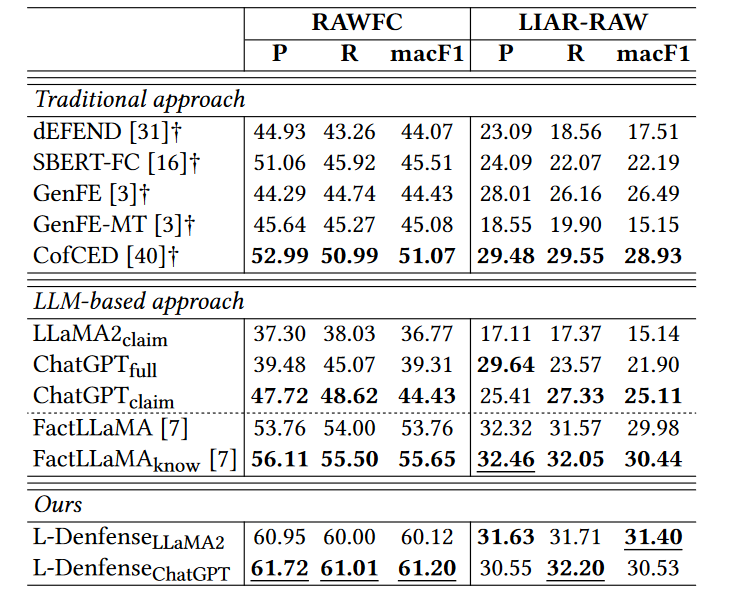

8.3.1 性能实验

(1)传统方法的表现:

大多数传统方法的表现不如ChatGPTclaim,这表明大语言模型(LLMs)在假新闻检测中具有潜力。

(2)三种未调优的LLM方法:

在前三种未经过任何调优的LLM方法中,ChatGPTclaim取得了最好的结果。LLaMA2claim的表现较差,可能是因为其模型规模显著小于ChatGPT。ChatGPTfull表现不佳的一个可能原因是LLM容易受到大量输入报告的偏见影响。

(3)与传统方法中的最佳方法对比:

尽管ChatGPTclaim表现良好,但与传统方法中的最佳方法CofCED相比仍显不足。相比之下,经过微调的LLM模型(即FactLLaMA和FactLLaMAknow)在作者提出的模型之外,表现最好。这表明仅仅利用LLMs进行推理效果有限,而仔细考虑如何进一步利用LLMs可以带来更好的性能。

(4)作者提出的模型的表现:

作者的模型在一个新的防御框架中利用LLM作为推理器,在真假性预测上取得了出色的结果,特别是在RAWFC数据集上的提升尤为显著。与FactLLaMAknow相比,作者的模型在所有指标上至少提高了4%。

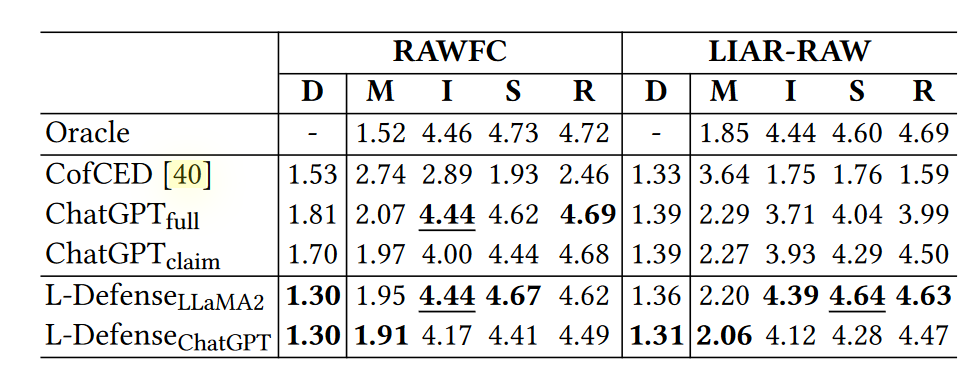

8.3.2 文本质量评估

(实验一)

在没有参考文本的情况下,ChatGPT 也能从以下几个角度评估文本质量:

误导性(Misleadingness, M):评估模型解释与真实声明标签的一致性(越小越好)

信息性(Informativeness, I):评估解释是否提供新信息,如背景和附加上下文(越大越好)

合理性(Soundness, S):描述解释是否有效且合乎逻辑(越大越好)

可读性(Readability, R):评估解释是否遵循正确的语法和结构规则,句子是否连贯易读(越大越好)

差异度(Discrepancy,D):不考虑解释质量,通过计算预测标签和实际标签分数的绝对差值来获得(越小越好)

效果如下所示,其中,Oracle 通过向 ChatGPT 提供声明和实际准确性标签,生成声明为何被分类为其实际准确性标签的解释,可当做是一种性能的最高标准。

如表8-3是ChatGPT评估文本质量的结果。由于CofCED通过从报告中提取来生成解释,因此离散的证据句子很难组合在一起并且可能会重叠。因此,与其他基于LLM的模型相比,它的解释取得了最差的性能。此外,其不连贯的解释导致较高的误导性分数,尽管差异分数要好得多。这证明了连贯性对于生成精简且易于理解的解释的重要性。就 ChatGPT 的两个版本而言,在后三个指标上,ChatGPTfull 在 RAWFC 上表现出比 ChatGPTclaim 更好的性能。然而,它在 LIAR-RAW 上的所有指标上都表现不佳。一个可能的原因是,在完整版本中,RAWFC 的输入长度大约是 LIAR-RAW 的两倍,从而包含了更多信息。同时,这也表明ChatGPT极易受到输入上下文的影响。与 ChatGPTclaim 相比,额外原始报告的引入导致 ChatGPTfull 中的性能完全不同。对于我们提出的 L-Defense 的两个变体,ChatGPT 变体在误导性相关指标上总是击败 LLaMA2 变体,但在后三个指标上却输了。它进一步表明我们模型的性能不受 LLM 规模的限制

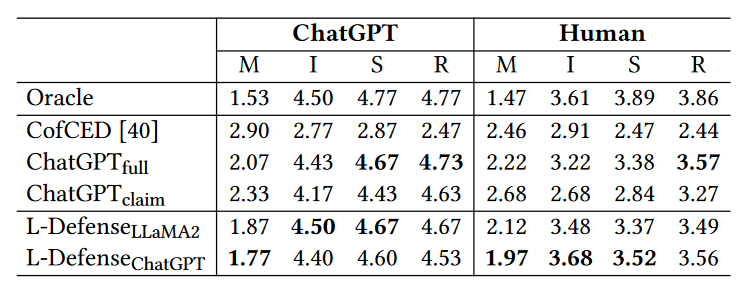

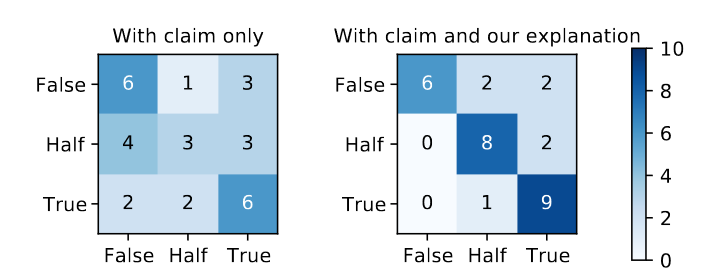

(实验二)

为了进一步验证LLMS评估的有效性以及我们提出的模型的有用性,本文邀请十名志愿者作为注释者,对解释质量进行了两次人工评估。如果表8-4,一方面,注释者对各种指标的评估结果与ChatGPT的排名基本一致。主要区别在于,人类更喜欢我们模型的 ChatGPT 变体做出的解释,而 ChatGPT 更喜欢 LLaMA2 变体。另一方面,如图8-5所示,我们提出的模型显着减少了错误判断,帮助人类理解真相。

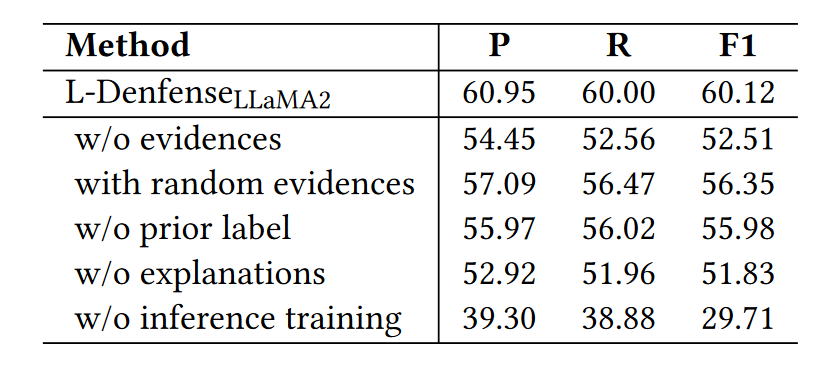

8.3.3 消融实验

从以下几个角度进行消融实验:

“w/o evidences”:从提示模板T中移除提取的竞争性证据E𝑣。

“with random evidence”:将E𝑣替换为随机抽取的句子。

“w/o prior label”:移除提示模板T中的给定先验真实性标签̃𝑦𝑣。

“w/o explanations”:在基于防御的推理中,将LLM生成的真实性解释𝑒𝑣替换为相应的提取竞争性证据E𝑣。

“w/o inference training”:将微调过程替换为ChatGPT的预测。

表8-6的结果显示,去除任何关键组件后的版本性能显著下降,表明每个组件对模型的整体性能都至关重要。

8.3.4 案例学习

案例学习回答了三个问题:

(1)证据提取模块是否成功从大量信息中分离出两组对立的证据?

如表6所示,L-Defense提取的前3名真证据和假证据集中在主张的不同观点上。真实的证据凸显了2009年奥巴马领导下的猪流感大流行后管理不善造成的口罩短缺。这些虚假证据表明特朗普没有注意到短缺问题,并表明该消息可能源于特朗普的影响力。这两个相互竞争的证据集与其各自的黄金理由一致,验证了证据提取模块的有效性。

(2)基于提示的模块生成的两组对立的解释是否有助于确定真实性?

根据提取的竞争证据,LLMs推理产生的两个理由表明,在主张的真实性上存在明显的竞争。由于它们的置信强度总体上相当,因此基于防御的推理模块给出了正确的预测。

(3)防御式策略是否缓解了多数偏见问题?

在提供相同信息的情况下,只有我们提出的模型才能做出正确的预测。 CofCED 的排名靠前的证据不包含任何有关真实方面的证据,并且受到第三个证据的偏见,导致错误分类。由于缺乏深入的思考或训练,ChatGPTfull 给出的理由忽略了真实的观点并预测该主张是错误的。相比之下,我们的框架受益于我们新颖的基于防御的策略,避免了这些问题。

9 总结

9.1优点

(1)在考虑问题细致,实验丰富,分析全面

(2)巧妙利用大语言模型和小语言模型各自的优势

(3)竞争双方的证据都被利用,减少了解释的偏见

(4)为在社交媒体中利用用户评论做虚假新闻检测与提供可解释性提供思路。

9.2不足

(1)Baseline的选取不够有代表性,并且对于Baseline的解释说明不足

(2)没有一个方法说明prompt是生成效果最好的

(3)性能分析图、案例图不直观